GPT-oss : OpenAI déploie deux modèles d'IA ouverts… jusqu'à un certain point

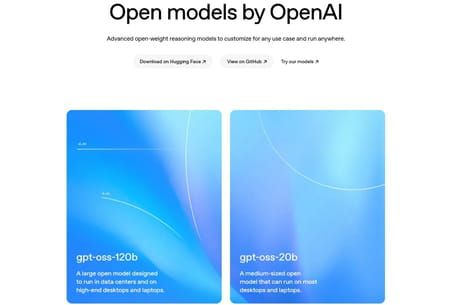

OpenAI lance ses premiers modèles de langage ouverts en six ans, GPT-oss-120B et GPT-oss-20B, que tout le monde peut utiliser gratuitement. L'un d'entre eux peut même fonctionner en local ! Mais attention, ouvert ne veut pas dire open source…

Contrairement à ce que suggère son nom, OpenAI, le papa de ChatGPT, est principalement connu pour ses modèles propriétaires. C'est bien simple, la dernière fois que l'entreprise a sorti un modèle en langage ouvert, c'était en 2019 avec GPT-2, soit bien avant le lancement de son IA vedette en 2022. Mais la firme de Sam Altman s'apprête à effectuer un retour aux sources — en partie du moins. Ainsi, le 5 août, OpenAI a dévoilé deux nouveaux modèles d'IA open weight : GPT-oss-120B et GPT-oss-20B (oss signifiant open source software). Publiés sous la licence Apache, ils sont téléchargeables gratuitement, peuvent être exécutés, modifiés et même intégrés dans des produits commerciaux. De plus, ils peuvent fonctionner en local et sans connexion Internet.

GPT-oss : des modèles d'IA gratuits qui tournent en local

Le modèle le plus imposant, GPT-oss-120B, possède 120 milliards de paramètres. Selon OpenAI, il est "égal" au modèle o4-mini — sorti en avril 2025 — sur les principales évaluations, et exige une carte graphique équipée de 80 Go de mémoire pour fonctionner. De son côté, GPT-oss-20B peut, avec ses 20 milliards de paramètres, tourner sur un appareil en local ayant au minimum 16 Go de mémoire vive — comme un ordinateur grand public avec une configuration un peu musclée ou un smartphone haut de gamme — tout en obtenant des résultats similaires à 03-mini.

Présentés comme capables de "raisonner" en exposant leur "flot de pensée", les deux modèles peuvent produire du texte, générer des images, naviguer sur Internet ou encore interagir avec un ordinateur. Grâce à leur licence Apache 2.0, ils peuvent être librement personnalisés, intégrés dans des applications et redistribués, y compris à des fins commerciales.

gpt-oss is out!

— Sam Altman (@sama) August 5, 2025

we made an open model that performs at the level of o4-mini and runs on a high-end laptop (WTF!!)

(and a smaller one that runs on a phone).

super proud of the team; big triumph of technology.

Le lancement de ces deux modèles était initialement prévu en juillet, mais il a été reporté pour des raisons de sécurité. Ainsi, OpenAI affirme avoir mené des tests approfondis sans détecter de risque critique. Plusieurs partenaires techniques — Microsoft, Hugging Face, AWS, Snowflake, Nvidia, entre autres — se sont associés à l'entreprise afin que leur déploiement se fasse sur le maximum d'environnements possibles, qu'il s'agisse de cloud ou d'appareils locaux. Une boîte à outils, des guides et un playground de test sont mis à disposition de tous.

GPT-oss : des modèles ouverts, mais pas open source

Attention, contrairement à ce qu'affirment certains titres de presse, ils ne sont pas open source, mais open weight. Cela signifie qu'OpenAI donne accès au poids des paramètres, mais pas au code source complet, aux données d'entraînement, ni aux droits pour modifier ou redistribuer toute la chaîne de développement — ce qui caractérise un vrai projet open source. Pour faire simple, cela permet d'en savoir plus sur le fonctionnement des modèles, et donc sur comment ils vont "agir", quels seront les résultats, mais pas de modifier les biais d'entraînement ou la manière dont les connexions sont faites.

Pour faire une analogie, c'est comme si on avait accès, pour un modèle open source, à une recette de cuisine complète (ingrédients, proportions, étapes, temps de cuisson), que l'on peut ensuite modifier, améliorer et partager. Alors qu'avec un modèle open weight, on nous donne le gâteau déjà cuit : on peut le manger, le découper, l'utiliser dans une autre préparation ou le revendre, mais on ne sait pas exactement comment il a été fait, ni comment reproduire le même résultat en partant de zéro. En choisissant de rendre ses modèles open weight, OpenAI trouve un compromis : il minimise le risque de fuite de propriété intellectuelle, tout en réaffirmant sa présence dans l'écosystème ouvert de l'IA.

Ce changement de direction de la part de l'entreprise n'arrive pas par hasard. En effet, les modèles chinois, notamment DeepSeek et Qwen d'Alibaba, ont mis un sacré coup de pied dans la fourmilière en début d'année, en publiant des modèles open-weight proposant des performances impressionnantes à moindres coûts. Meta n'est pas en reste avec sa gamme Llama, de même que le Français Mistral, qui a carrément publié son code en open source. À présent, il ne reste plus qu'à attendre la sortie de GPT-5, qui pourrait survenir en août.